Sensores CMOS de Visión, Gestión de Energía y Seguimiento de Objetos sobre GPUs empotradas

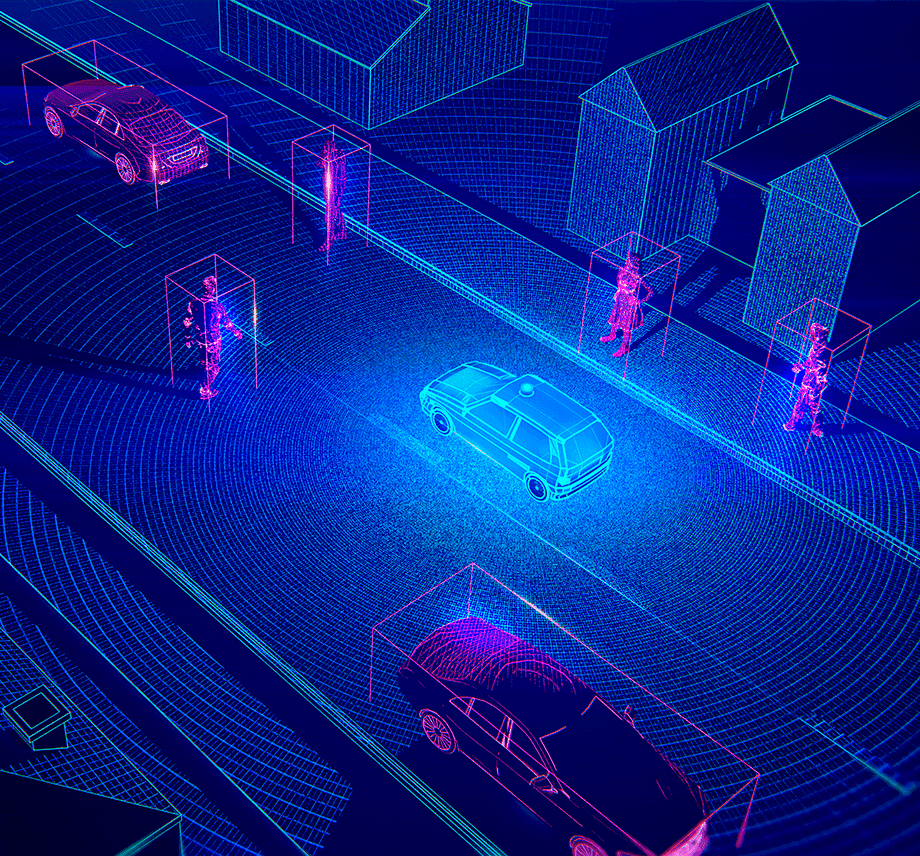

Nuestro subproyecto se enmarca en sensado y procesamiento en lo que se conoce como edge o periferia del sistema, donde el área, tamaño y consumo de potencia están limitados de forma severa.

En la capa de sensado nos centramos en el descriptor de flujo local agregado (ALFD) que proporciona una representación dispersa y enriquecida de los objetos de la escena para su procesamiento posterior en tareas como seguimiento de objetos. ALFD es el elemento central del algoritmo NOMT, que se sitúa en los primeros puestos del reto MOT de seguimiento de múltiples objetos, lo que garantiza gran precisión. El objetivo es implementar ALFD en un sensor CMOS de visión de bajo tamaño, peso y potencia, lo que facilitaría su uso en infraestructuras a lo largo de carreteras o en drones. Durante el diseño surgirán retos científicos en temas como el diseño de memorias con gran capacidad de retención temporal o la reutilización de bloques de procesamiento en diferentes etapas del algoritmo para disminuir tanto área como consumo de potencia. Introducimos también técnicas de recolección de energía con el objetivo final de lograr sistemas de visión CMOS autoalimentados.

Nuestra experiencia previa incluye una unidad de gestión de la energía dentro del chip (Power Management Unit, PMU) con una única salida en voltaje no regulado en el rango de nW a uW. Esta PMU es el punto de partida para una nueva versión con varias salidas en voltaje reguladas para llegar hasta los mW. Esto nos permitirá abordar aplicaciones en internet de las cosas (IoT) para monitorización de tráfico, al tiempo que podremos trabajar con voltajes menores con el chip dormido y con voltajes más elevados con el chip procesando, lo que redunda en una mayor precisión y menor consumo global.

Planteamos también el diseño de un chip CMOS en tecnología CIS en modo dual, con recolección activa de energía con la PMU mejorada discutida anteriormente, y procesamiento para seguimiento de objetos mediante substracción de fondo de las imágenes

captadas.

En la capa de aplicación nos centramos en detección y seguimiento de objetos mediante aprendizaje profundo (deep learning, DL), donde tenemos experiencia a través de proyectos de transferencia en aplicaciones como conteo y clasificación de vehículos. Esto nos permite conocer las especificaciones para el diseño de hardware. En este sentido, plantearemos el uso de GPUs embebidas como hardware base, lo que típicamente lleva a tiempos de diseño más cortos que la contrapartida ASIC, y por tanto a mayor flexibilidad para adaptarse a los continuos cambios en el campo de de DL. Nuestro objetivo final es ejecutar algoritmos del estado del arte, lo que garantiza alta precisión, en sistemas basados en GPUs alimentados mediante baterías para facilitar su uso en tareas de monitorización de tráfico tanto en postes fijos situados a lo largo de la vía como en plataformas móviles como vehículos o UAVs. Para lograr esto, será necesario rediseñar algunos algoritmos de DL mediante simplificación de la estructura de capas o la reducción del número de bits de los pesos de la red.

En resumen, este proyecto se centra en sensado y procesado en la periferia o borde de sistemas, lo que exige bajo consumo sin degradar la precisión, de ahí que hayamos optado por sensores de visión CMOS con gestión eficiente de la energía y GPUs de bajo consumo. Como ámbito de aplicación, nos centramos en detección y seguimiento de objetos, central a muchas aplicaciones de monitorización de tráfico.

Proyecto

/research/projects/sensores-cmos-de-vision-xestion-de-enerxia-e-seguimento-de-obxectos-sobre-gpus-empotradas

<p>Nuestro subproyecto se enmarca en sensado y procesamiento en lo que se conoce como edge o periferia del sistema, donde el área, tamaño y consumo de potencia están limitados de forma severa.<br />En la capa de sensado nos centramos en el descriptor de flujo local agregado (ALFD) que proporciona una representación dispersa y enriquecida de los objetos de la escena para su procesamiento posterior en tareas como seguimiento de objetos. ALFD es el elemento central del algoritmo NOMT, que se sitúa en los primeros puestos del reto MOT de seguimiento de múltiples objetos, lo que garantiza gran precisión. El objetivo es implementar ALFD en un sensor CMOS de visión de bajo tamaño, peso y potencia, lo que facilitaría su uso en infraestructuras a lo largo de carreteras o en drones. Durante el diseño surgirán retos científicos en temas como el diseño de memorias con gran capacidad de retención temporal o la reutilización de bloques de procesamiento en diferentes etapas del algoritmo para disminuir tanto área como consumo de potencia. Introducimos también técnicas de recolección de energía con el objetivo final de lograr sistemas de visión CMOS autoalimentados.<br />Nuestra experiencia previa incluye una unidad de gestión de la energía dentro del chip (Power Management Unit, PMU) con una única salida en voltaje no regulado en el rango de nW a uW. Esta PMU es el punto de partida para una nueva versión con varias salidas en voltaje reguladas para llegar hasta los mW. Esto nos permitirá abordar aplicaciones en internet de las cosas (IoT) para monitorización de tráfico, al tiempo que podremos trabajar con voltajes menores con el chip dormido y con voltajes más elevados con el chip procesando, lo que redunda en una mayor precisión y menor consumo global.<br />Planteamos también el diseño de un chip CMOS en tecnología CIS en modo dual, con recolección activa de energía con la PMU mejorada discutida anteriormente, y procesamiento para seguimiento de objetos mediante substracción de fondo de las imágenes<br />captadas.</p> <p>En la capa de aplicación nos centramos en detección y seguimiento de objetos mediante aprendizaje profundo (deep learning, DL), donde tenemos experiencia a través de proyectos de transferencia en aplicaciones como conteo y clasificación de vehículos. Esto nos permite conocer las especificaciones para el diseño de hardware. En este sentido, plantearemos el uso de GPUs embebidas como hardware base, lo que típicamente lleva a tiempos de diseño más cortos que la contrapartida ASIC, y por tanto a mayor flexibilidad para adaptarse a los continuos cambios en el campo de de DL. Nuestro objetivo final es ejecutar algoritmos del estado del arte, lo que garantiza alta precisión, en sistemas basados en GPUs alimentados mediante baterías para facilitar su uso en tareas de monitorización de tráfico tanto en postes fijos situados a lo largo de la vía como en plataformas móviles como vehículos o UAVs. Para lograr esto, será necesario rediseñar algunos algoritmos de DL mediante simplificación de la estructura de capas o la reducción del número de bits de los pesos de la red.</p> <p><br />En resumen, este proyecto se centra en sensado y procesado en la periferia o borde de sistemas, lo que exige bajo consumo sin degradar la precisión, de ahí que hayamos optado por sensores de visión CMOS con gestión eficiente de la energía y GPUs de bajo consumo. Como ámbito de aplicación, nos centramos en detección y seguimiento de objetos, central a muchas aplicaciones de monitorización de tráfico.</p> - Víctor Manuel Brea Sánchez, Paula López Martínez - Diego Cabello Ferrer

projects_es